* Marcus R. Munafò, Brian A. Nosek, Dorothy V. M. Bishop,

Katherine S. Button, Christopher D. Chambers, Nathalie Percie du Sert,

Uri Simonsohn, Eric-Jan Wagenmakers, Jennifer J. Ware & John P. A. Ioannidis

Melhorar a confiabilidade e a eficiência da pesquisa científica aumentará a credibilidade da literatura científica publicada e acelerará descobertas. Aqui nós defendemos a adoção de medidas para otimizar os elementos chave do processo científico: métodos, relatório e divulgação, reprodutibilidade, avaliação e incentivos. Há evidências tanto de simulações quanto de estudos empíricos que suportam a efetividade dessas medidas, mas sua ampla adoção por pesquisadores, instituições, financiadores e publicações exigirá avaliação e melhorias iterativas. Nós discutimos os objetivos dessas medidas, e como elas podem ser implementadas, na esperança de que isso vá facilitar ações que aumentem a transparência, reprodutibilidade e eficiência da pesquisa científica.

Qual proporção da pesquisa publicada é provável que seja falsa? Pequeno tamanho amostral, efeitos pequenos, mineração de dados (também conhecido como P-hacking), conflitos de interesse, grande número de cientistas trabalhando de maneira competitiva em silos sem combinar seus esforços e assim por diante podem conspirar para aumentar drasticamente a probabilidade de uma descoberta publicada estar incorreta1. O campo da metaciência — o estudo científica da ciência em si — está florescendo e tem gerado evidências empíricas substanciais para a existência e prevalência de ameaças à eficiência na acumulação de conhecimento 2, 3, 4, 5, 6, 7, figura 1.

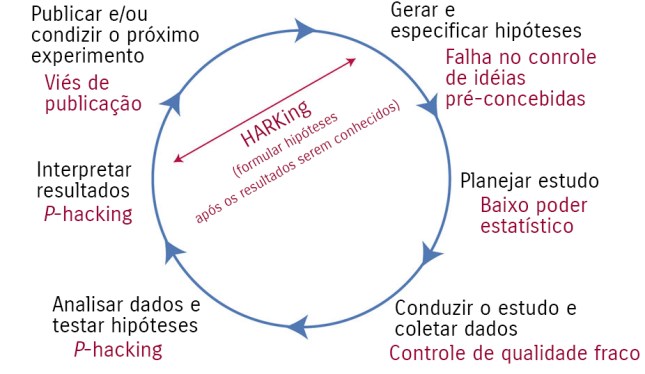

Figura 1: ameaças à ciência reprodutível

Uma versão idealizada do modelo hipotético-dedutivo do método científico é mostrada aqui. Existem várias ameaças potenciais para este modelo (indicadas em vermelho), incluindo a falta de replicação5, a hipótese após os resultados serem conhecidos (HARKing – Hypothesizing After the Results are Known)7, planejamento de estudo fraco, baixo poder estatístico2, flexibilidade analítica51, P-hacking4, viés de publicação3 e falta de dados compartilhandos6. Juntas, essas ameaças servirão para minar a robustez da pesquisa publicada e também pode afetar a capacidade da ciência de se auto-corrigir.

Dados de muitas fontes sugerem que a reprodutibilidade está abaixo do desejado 8, 9, 10,

11, 12, 13, 14. Uma análise estima que 85% dos esforços em pesquisa biomédica estão desperdiçados14, enquanto 90% dos entrevistados para uma pesquisa recente na Nature concordam que há uma “crise de reprodutibilidade”15. Se ‘crise” é um termo apropriado para descrever o estado atual ou a trajetória da ciência é discutível, mas evidências acumuladas indicam que há um espaço substancial para melhoria com relação às práticas de pesquisa para maximizar a eficiência do uso pela comunidade de pesquisa do investimento financeiro público em pesquisa.

Aqui nós propomos uma série de medidas que acreditamos que irão melhorar a eficiência e robustez da pesquisa de descobertas científicas mirando ameaças específicas à ciência reprodutível. Nós argumentamos pela adoção, avaliação e melhoria contínuos dessas medidas para otimizar a paz e eficiência da acumulação do conhecimento. As medidas estão organizadas em nas seguintes categorias16: métodos, relatório e disseminação, reprodutibilidade, avaliação e incentivos. Elas não intencionam ser exaustivas, mas prover uma série de ações amplas, práticas e baseadas em evidências que podem ser implementadas por pesquisadores, instituições, periódicos e financiadores. As medidas e sua implementação atual estão resumidas na Tabela 1.

| Tema | Propostas | Exemplos de iniciativas/soluções potenciais (estendendo a adoção atual) | Partes interessadas |

|---|---|---|---|

| Métodos | Proteção contra tendências cognitivas | Todas as iniciativas listadas abaixo (de * a ****) Experimento cego (**) |

P, F |

| Melhoria do treinamento metodológico | Treinamento rigoroso em estatística e métodos de pesquisa para futuros pesquisadores (*) Rigorosa educação continuada em estatística e métodos para pesquisadores (*) |

I, F | |

| Suporte metodológico independente | Envolvimento de metodologistas na pesquisa (**) Supervisão independente (*) |

F | |

| Colaboração e equipes científicas | Estudos multi-site/coleta de dados distribuídos (*) Consórcio de equipes científicas (*) |

I, F | |

| Relatório e disseminação | Promovendo o pré-registro da pesquisa | Relatórios Registrados (*) Estrutura de Ciência Aberta (*) |

P, F |

| Melhorando a qualidade dos relatórios | Uso de checklists de relatórios (**) Checklists de protocolo (*) |

P | |

| Protegendo de conflitos de interesse | Descoberta de conflitos de interesse (***) Exclusão/contenção de conflitos de interesse financeiros e não financeiros (*) |

P | |

| Reprodutibilidade | Encorajando transparência e ciência aberta | Dados abertos, materiais, software e assim por diante (* a **) Pré-registro (**** para testes clínicos, * para outros estudos) |

P, F, R |

| Avaliação | Diversificando revisão por pares | Pré impressões(* em ciências biomédicas/comportamentais, **** em ciências físicas) Revisão por pares na pré e pós publicação, por exemplo, Publons, PubMed Commons (*) |

P |

| Isentivos | Premiando práticas abertas e reprodutíveis | Distintivos (*) Relatórios registrados (*) Diretrizes de promoção de transparência e abertura(*) Estudos de replicação de financiamento (*) Práticas de ciência aberta na contratação e promoção (*) |

P, I, F |

| Extensão estimada da adoção corrente: * menor que 5% ** 5-30% *** 30-60% **** maior que 60%. Abreviação das partes chave interessadas: P – periódicos/editoras F – financiadores I – instituições R – reguladores |

|||

O problema

Uma característica da criatividade científica é a capacidade de ver padrões novos e inesperados nos dados. A identificação de John Snow da ligação entre cólera e abastecimento de água17, o trabalho de Paul Broca sobre a lateralização da linguagem18, a descoberta de Jocelyn Bell Burnell dos pulsares19 são exemplos de avanços alcançados pela interpretação de observações de uma nova maneira. Entretanto o maior desafio para os cientistas é ser abertos a novas e importantes intuições enquanto simultaneamente evitam ser enganados pela nossa tendência de ver estrutura na aleatoriedade. A combinação da apofenia (tendência de ver padrões em dados aleatórios), viés de confirmação (a tendência do focar na evidência que está alinhada com nossa expectativa ou explicação favorita) e viés retrospectivo (a tendência de ver um evento como sendo previsível somente depois que ocorreu) podem facilmente nos levar a falsas conclusões20. Thomas Levenson documentou o exemplo de astrônomos que se convenceram de ter visto o planeta ficcional de Vulcano porque suas teorias contemporâneas predisseram sua existência21. Os efeitos experimentais são um exemplo desse tipo de viés22.

A interpretação excessiva do ruído é facilitada pela medida em que a análise de dados é rápida, flexível e automatizada23. Em um conjunto de dados de alta dimensão, pode haver centenas ou milhares de abordagens alternativas razoáveis para analisar os mesmos dados24, 25. Por exemplo, em uma revisão sistemática de um estudo de imagem de ressonância magnética funcional (fMRI), Carp demonstrou que havia quase tantas vias analíticas únicas quanto haviam de estudos26. Se vários milhares de vias analíticas potenciais puderem ser aplicados a dados de alta dimensão, a geração de falsos positivos é altamente provável. Por exemplo, aplicar quase 7 mil vias analíticas a um único conjunto de dados de fMRI resultou em quase 90% de voxels cerebrais mostrando ativação significante em pelo menos uma análise27.

Durante a análise de dados pode ser difícil para pesquisadores reconhecer P-hacking28 ou mineração de dados porque vieses de confirmação e retrospectiva podem encorajar a aceitação de resultados que satisfaçam expectativas ou desejos como apropriados e a rejeição de resultados que não como consequência de projetos ou análises sub-ótimos. Podem surgir hipóteses que se encaixam nos dados e, em seguida, são relatadas sem indicação ou reconhecimento de sua origem post hoc7. Isso, infelizmente, não é descoberta científica, mas auto-engano29. Sem controle, pode aumentar dramaticamente a taxa de descobertas falsas. Precisamos de medidas para combater a tendência natural de cientistas entusiastas que são motivados pela descoberta para ver padrões no ruído.

Métodos

Nesta seção nós descrevemos medidas que podem ser implementadas enquanto a pesquisa é realizada (incluindo, por exemplo, projeto de estudo, métodos, estatísticas e colaboração).

Proteção contra vieses cognitivos

Há uma literatura substancial sobre a dificuldade de evitar tendências cognitivas. Uma solução efetiva para mitigar o auto-engano e tendências indesejadas é o cegamento. Em alguns contextos de pesquisa, participantes e coletores de dados pode ser cegados para a condição experimental que participantes são designados e para a hipótese de pesquisa, enquanto a análise de dados pode ser cegada para partes chave dos dados. Por exemplo, durante a preparação e limpeza dos dados, a identidade das condições experimentais ou os rótulos variáveis podem ser mascarados para que a saída não seja interpretável em termos da hipótese de pesquisa. Em algumas ciências físicas, essa abordagem tem sido estendida para incluir perturbações deliberadas ou mascaramento de dados para permitir a preparação dos dados (por exemplo, identificando de aberrações) para prosseguir sem que o analista seja capaz de ver os resultados correspondentes30. O pré-registro do projeto do estudo, do(s) resultado(s) primário(s) e do plano de análise (veja a seção “Promover estudo pré-registro”, abaixo) é uma forma altamente ativa de cegamento porque os dados não existem e os resultados ainda não são conhecidos.

Melhoria do treinamento metodológico

Projeto de pesquisa e análise estatística são mutualmente dependentes. Percepões equivocadas comuns, como a interpretação de valores de P31, limitações de testes de significância de hipótese nula32, o significado e a importância do poder estatístico2, a precisão dos tamanhos de efeitos relatados33 e a probabilidade do tamanho da amostra gerar uma descoberta estatisticamente significativa também ser adequada para replicar uma descoberta verdadeira34, poderiam todos ser enfrentados através de um treinamento estatístico aprimorado. Da mesma forma, os princípios básicos do projeto são importantes, assim como o cegamento para reduzir o viés de expectativa, randomização ou equilíbrio para controle de confusão e o uso de projetos no âmbito do tema, onde possível, para maximizar a potência. Entretanto, o treinamento integrativo em práticas de pesquisa que podem se proteger contra tendências cognitivas e os efeitos de incentivos distorcidos é, sem dúvida, mais importante. Além disso, melhores práticas estatísticas e metodológicas estão sob constante revisão e melhoria, de modo que tanto pesquisadores sênior quanto júnior precisam de educação metodológica contínua, principalmente porque grande parte do treino de início de carreira é informal e flui de seu supervisor ou mentor. Uma falha para adotar avanços em metodologia — como o progresso muito lento em aumentar o poder estatístico35, 36 — pode ser em parte em função da falha em imprimir uma educação profissional contínua e desenvolvimento ético.

Sem os requerimentos formais para uma educação contínua, as soluções mais efetivas podem ser desenvolver recursos educacionais que sejam acessíveis, fáceis de digerir e aplicáveis imediatamente e efetivamente à pesquisa (por exemplo, módulos breves, baseados na web para tópicos específicos e combinações de módulos que sejam customizados para aplicações de pesquisa particulares). Uma abordagem modular simplifica o processo de atualização iterativa desses materiais. Softwares de demonstração e exemplos práticos podem ainda fazer lições e implicações particularmente tangíveis para pesquisadores em qualquer estágio da carreira: o Assistente de Projeto Experimental suporta projetos de pesquisa para todos os experimentos animais, enquanto o P-hacker demonstra o quão fácil é gerar resultados que aparentam ser descobertas estatisticamente significativas explorando flexibilidades analíticas.

Implementando suporte metodológico independente

A necessidade de um suporte metodológico independente é bem estabelecida em algumas áreas — alguns testes clínicos, por exemplo, tem comitês multidisciplinares de direção de ensaios para fornecer aconselhamento e supervisionar o projeto e a condução do teste. A necessidade desses comitês surgiu dos bem conhecidos conflitos de interesse financeiros que existem em vários testes clínicos. O patrocinador de um teste pode ser a empresa que fabrica o produto e qualquer influência intencional ou não intencional pode distorcer o projeto, análises e interpretação dos resultados do estudo para benefício financeiro definitivo da empresa ao custo da precisão da ciência e do benefício da saúde do consumidor37, 38. Conflitos de interesses não financeiros também existem, como as crenças e preconceitos do cientista individualmente e as apostas que os pesquisadores tem em obter resultados publicáveis de maneira a progredir sua carreira39, 40. Incluindo pesquisadores independentes (particularmente metodologistas sem nenhum investimento pessoal no tópico de pesquisa) no projeto, monitoramento, análise ou interpretação dos resultados da pesquisa pode mitigar algumas dessas influências e pode ser feito tanto no nível do projeto de pesquisa individual ou através de processos facilitados por uma agência de financiamento (veja o Quadro 1).

Quadro 1 – Supervisão independente: o caso da Fundação CHDI.

Encorajando a colaboração e equipe científica

Estudos sobre potência estatística continuam indicando estar abaixo (às vezes muito abaixo) de 50% em ambos os tempos e nas diferentes disciplinas estudadas.2, 35, 36. Baixa potência estatística aumentam a possibilidade de obter resultados tanto falsos positivos quanto falsos negativos2, o que significa que não oferece nenhuma vantagem se o objetivo é acumular conhecimento. Apesar disso, pesquisas de baixa potência persistem por conta de incentivos disfuncionais, pobre compreensão das consequência da baixa potência e a falta de recursos para melhorar essa potência. Equipe científica é uma solução para o último problema — ao invés de confiar nos recursos limitados de investigadores solitários, colaboração distribuída através de vários locais de estudo facilitam projetos de alta potência e maior potencial para testar a generalização em todas as configurações e populações amostradas. Isso também traz um maior alcance para múltiplas perspectivas teóricas e disciplinares e uma gama diversificada de culturas de pesquisa e experiências a serem incorporadas no projeto de pesquisa.

Esforços multicêntricos e colaborativos tem uma longa e bem sucedida em campos como ensaios controlados randomizados em algumas áreas da medicina clínica e em análises de associação genética e tem melhorado a robustez da literatura de pesquisa resultante. Projetos colaborativos multilocalizados também foram defendidos para outros tipos de pesquisa, como estudos em animais41, 42, 43 em um esforço para maximizar sua potência, melhorar a padronização e otimizar a transparência e a proteção de ideias preconcebidas. Os projetos The Many Labs ilustram esse potencial em ciências sociais e comportamentais, com dezenas de laboratórios implementando o mesmo protocolo de pesquisa para obter estimativas de alta precisão de tamanhos de efeito e avaliar a variabilidade entre amostras e configurações44, 45. Isso também é possível, e desejável, para incorporar um ethos de equipe científica nos treinamentos de estudantes (veja o Quadro 2).

Quadro 2 – Projetos de estudantes distribuídos.

Os requisitos de avaliação dos estudantes e acesso limitado às populações de interesse podem dificultar a colaboração extensa dentro de uma mesma instituição, mas isso pode ser alcançado entre múltiplas instituições na forma de um projeto e estudantes distribuído. Sob este modelo, acadêmicos e estudantes de várias instituições podem formar um consórcio, desenvolvendo colaborativamente um questão de pesquisa, protocolo e plano de análise e pré-registrar isso publicamente antes da coleta dos dados. O protocolo deve ser implementado por cada estudante em cada centro participante e os dados resultantes reunidos para análise. Reuniões do consórcio antes e depois da coleta dos dados podem ser usados para integrar o treinamento em projeto de pesquisa, enquanto oferece oportunidades para contribuição criativa pelos estudantes. Conclusões baseadas nos resultados seriam ser mutuamente acordadas na preparação para disseminação ampla, usando inclusive convenções de autoria como as adotadas por consórcios genéricos. Os estudantes aprenderiam métodos rigorosos de pesquisa através da participação ativa em pesquisas que são suficientemente bem projetadas e condizidas para serem genuinamente significativas. Criticamente, a ciência da equipe colaborativa seria instilada em um estágio inicial de treinamento.

O Projeto de Replicação Colaborativa e Educação (CREP – Collaborative Replications and Education Project) é um exemplo desse conceito em psicologia, de uma forma mais centralizada. Uma equipe de coordenação identifica pesquisas publicadas recentemente que poderiam ser replicadas no contexto de um curso semestral de graduação em métodos de pesquisa. Um meio comum fornece os materiais e orientações para incorporar as replicações em projetos ou classes e os dados coletados entre os locais são agregados nos manuscritos para publicação. Os projetos Pipeline78 e Many Labs44, 45 também oferecem oportunidades para contribuir esforços de replicação em larga escala com coleta de dados coordenada através de vários locais simultaneamente.

Relatório e disseminação

Nesta seção nós descrevemos medidas que podem ser implementadas quando da comunicação da pesquisa (incluindo, por exemplo, padrões de relatório, pré-registro do estudo e descoberta de conflitos de interesse).

Promovendo o pré-registro dos estudos

O pré-registro de protocolos de estudo para testes randomizados controlados em medicina clínica se tornou uma prática padrão46. Na sua forma mais simples, ele pode simplesmente incluir o registro do projeto de estudo básico, mas também pode incluir uma pré-especificação detalhada dos procedimentos de estudo, resultados e plano de análise estatística. Isso foi introduzido para abordar dois problemas: viés de publicação e flexibilidade analítica (em particular resultados mudando na caso da medicina clínica). O viés de publicação47, também conhecido como o problema da gaveta do arquivo48, se refere ao fato de que muito mais estudos são realizados do que publicados. Estudos que obtêm resultados positivos e novos são mais propensos a serem publicados do que estudos que obtêm resultados negativos ou replicações de resultados anteriores47, 49, 50. A consequência é que a literatura publicada indica evidências mais fortes de descobertas do que existe na realidade. Mudança de resultados se refere à possibilidade de alterar os resultados de interesse em um estudo dependendo dos dados observados. Um pesquisador pode incluir dez variáveis que podem ser consideradas resultados de saída da pesquisa e — uma vez que os dados são conhecidos — intencionalmente ou não selecionar um subconjunto de resultados que mostram dados estatisticamente significativos como um resultado de interesse. A consequência é um aumento na probabilidade de resultados reportados serem falsificados pela chance de lucro, enquanto evidências negativas são ignoradas. Esta é uma das várias práticas relacionadas com pesquisas que podem inflar descobertas falsas enquanto as decisões de análise são feitas com conhecimento dos dados observados, como seleção de modelos, regras de exclusão e covariáveis. Essas decisões de análise contigenciadas pelos dados constituem o que ficou conhecido por P-hacking51 e o pré-registro pode proteger contra tudo isso.

A forma forte de pré-registro envolve tanto o registro do estudo (com um compromisso de tornar públicos os resultados) e pré-especificar rigorosamente o projeto de estudo, resultado primário e plano de análise, antes de conduzir o estudo ou conhecer o resultado da pesquisa. Em princípio, isso endereça o viés de publicação tornando todas as pesquisas transparentes, sejam ou não publicadas, permitindo que todas as evidências sobre uma descoberta sejam obtidas e avaliadas. Isso também endereça as mudanças de resultados e P-hacking mais genericamente ao exigir que o pesquisador articule decisões analíticas antes de observar os dados, assim essas decisões permanecem independentes dos dados. Criticamente, isso também deixa clara a distinção entre pesquisa confirmatória independente dos dados, que é importante para testar hipóteses, e pesquisa exploratória contingenciada por dados, que é importante para gerar hipóteses.

Enquanto o registro prévio é comum atualmente em algumas áreas da medicina clínica (devido a requisitos de periódicos e órgãos reguladores, como a Food and Drug Administration (FDA), é raro nas ciência sociais e comportamentais. Entretanto, o apoio ao registro prévio de estudos está aumentando. Sites como o da Open Science Framework e AsPredicted oferecem serviços para estudos pré-registrados o Preregistration Challenge oferece educação e incentivos para conduzir pesquisas pré-registradas e periódicos estão adotando os formatos de publicação de Relatórios Registrados52, 53 para encorajar o registro prévio e adicionar a revisão de pares cega ao resultado (veja o Quadro 3).

Quadro 3 – Relatórios Registrados

A iniciativa de Relatórios Registrados (RR) procura eliminar várias formas de tendências em pesquisas orientadas a hipóteses52, 53 e, em particular, a avaliação de um estudo baseado em resultados. Diferentes dos artigos nos periódicos convencionais, RR dividem o processo de revisão por pares em duas etapas, antes e depois de os resultados serem conhecidos. No primeiro estágio, revisores e editores avaliam um protocolo detalhado que inclui o raciocínio do estudo, procedimento e plano de análise detalhado. Após análise favorável (e provavelmente revisão para atender a padrões metodológicos estritos), o periódico oferece uma aceitação em princípio: a publicação dos resultados do estudo é garantida desde que os autores mantenham aderência ao protocolo aprovado, o estudo mantenha verificações de qualidade pré-especificadas e as conclusões sejam apropriadamente vinculadas à evidência. Uma vez que o estudo esteja completo, os autores reenviam um manuscrito completo que inclui os resultados e a discussão. I artigo é publicado ao final desse processo de duas etapas. Ao aceitar artigos antes do resultado ser conhecido, RR previnem o viés de publicação. Ao revisar antecipadamente a hipótese e os planos de análise, RR também ajudam a neutralizar o P-hacking e o HARKing (formular hipótese após os resultados serem conhecidos) pelos autores e CARKing (crítica após dos resultados serem conhecidos) pelos revisores com seus próprios investimentos no resultado da pesquisa, embora sejam necessárias evidências empíricas para confirmar que este é o caso.Talvez a objeção mais comum ao RR é que o formato de alguma forma limite a exploração ou criatividade ao requerer que os autores a adoção a uma metodologia especificada previamente. Entretanto, RR não coloca restrições à análise criativa ou serendipidade. Autores são livres para reportar os resultados de qualquer análise exploratória não registrada, desde que esses testes sejam claramente rotulados como post hoc. Portanto, o único requisito é que resultados exploratórios sejam identificados de forma transparente como sendo exploratórios (para uma lista de perguntas frequentes, veja cos.io/rr/#faq). Claro, RR não se destinam a pesquisas que sejam somente exploratórias.

A partir de novembro de 2016, RR tem sido adotado por mais de 40 periódicos, incluindo Nature Human Behaviour, cobrindo uma ampla gama de ciências da vida, sociais e físicas (para uma lista organizada, veja cos.io/rr/#journals). O conceito também abre a porta para formas alternativas de financiamento de pesquisa que proporcionem recompensa por transparência e reprodutibilidade. Por exemplo, autores podem enviar uma proposta detalhada antes de ter financiamento para sua pesquisa. Na sequência da análise simultânea tanto pelo agente financiador quanto pelo periódico, as propostas mais fortes receberiam o apoio financeiro do financiador e a aceitação a priori da publicação pelo periódico (veja cos.io/rr/#funders).

Melhorando a qualidade do relatório

O pré registro melhorará a encontrabilidade da pesquisa, mas encontrabilidade não garante usabilidade. Usabilidade ruim reflete a dificuldade em avaliar o que foi feito, em reutilizar a metodologia para avaliar a reprodutibilidade e em incorporar a evidência em revisões sistemáticas e metanálises. A melhora na qualidade e transparência no relatório da pesquisa é necessária para endereçar isso. As diretrizes da Promoção de Transparência e Abertura (TOP – Transparency and Openness Promotion) oferecem padrões como base para periódicos e financiadores para incentivar ou requerer grande transparência no planejamento e relatório da pesquisa54. TOP provê princípios de como a transparência e usabilidade podem ser melhorados, enquanto outras diretrizes fornecem etapas concretas de como maximizar a qualidade dos relatórios em áreas particulares. Por exemplo, a declaração de Normas Consolidadas de Relatórios de Experiências (CONSORT – Consolidated Standards of Reporting Trials) provê orientações para experiências controladas aleatórias claras, completas e com relatórios precisos56, 57, 55. Mais de 300 diretrizes de relatórios existem atualmente para estudos observacionais, estudos prognósticos, modelos preditivos, testes diagnósticos, revisões sistemáticas e metanálises em humanos, uma grande variedade de estudos usando métodos laboratoriais diferentes e estudos animais. A Equator Network agrega essas diretrizes para melhorar a encontrabilidade58. Também há diretrizes para melhorar o relatório do planejamento da pesquisa. Por exemplo, a declaração do Itens de Relatórios Preferidos para Análises Sistemáticas e Metanálises (PRISMA – Preferred Reporting Items for Systematic Reviews and Meta-Analyses) para relatórios de revisões sistemáticas e metanálises59 e o PRISMA-P para protocolos de revisões sistemáticas60. O fluxo de trabalho do Desafio do Pré-Registro e a receita de pré-inscrição para pesquisa social-comportamental61 também ilustram diretrizes para planos de relatório de pesquisa.

O sucesso das diretrizes de relatório dependem de sua adoção e uso efetivo. As ciências sociais e comportamentais estão atrás das ciências biomédicas em sua adoção de diretrizes de relatórios para pesquisas, apesar que, com a rápida adoção das diretrizes TOP e desenvolvimentos relacionados pelos periódicos e financiadores, essa lacuna pode ser fechada. Entretanto, relatórios melhorados podem ser em si insuficientes para maximizar a qualidade da pesquisa. Diretrizes de relatório são facilmente percebidas pelos pesquisadores como exercícios burocráticos ao invés de significar uma melhoria na pesquisa e no relatório. Mesmo com o pré-registro de testes clínicos, um estudo observou que apenas 13% dos testes publicaram resultados completamente resistentes com os compromissos pré-registrados. A maioria das publicações de testes não relataram resultados pré-registrados e adicionaram novos resultados que não eram parte do projeto registrado (veja em www.COMPare-trials.org). Franco e colegas observaram achados semelhantes em psicologia62. Usando protocolos pré-registrados e dados públicos do projeto Experimentos de Tempo Compartilhado para as Ciências Sociais (TESS – Time-sharing Experiments for the Social Sciences), eles descobriram que 40% dos relatórios publicados falharam em mencionar uma ou mais das condições experimentais dos testes e aproximadamente 70% dos relatórios publicados falharam em mencionar um ou mais dos mensuramentos de resultado incluídas no estudo. Além disso, mensuramentos de resultado que não estavam incluídos eram muito mais propensos a serem negativos e associados a efeitos de pequeno tamanho do que os mensuramentos que foram incluídos.

O resultado positivo das diretrizes de relatório é que elas tornam possível detectar e estudar esses comportamentos e seus impactos. De outra forma, esses comportamentos seriam simplesmente desconhecidos em qualquer maneira sistemática. O resultado negativo é que a evidência empírica das diretrizes de relatório podem ser necessárias, mas sozinhas não serão suficientes, para endereçar vieses de relatório. O impacto de diretrizes e como melhor otimizar seu uso e impacto serão melhor avaliadas em testes randomizados (veja o Quadro 4).

Quadro 4 – Evidência da efetividade das diretrizes de relatório

avaliar o impacto de manter uma lista de controle ARRIVE completa com envios manuscritos sobre a qualidade dos relatórios em artigos publicados (ecrf1.clinicaltrials.ed.ac.uk/iicarus). O sucesso desses esforços exigirão que publicações e financiadores adotem as diretrizes e auxiliem os ciclos iterativos de avaliações e melhorias da comunidade.

Reproducibilidade

Nesta seção nós descrevemos medidas que podem ser implantadas para auxiliar a verificação da pesquisa (incluindo, por exemplo, compartilhamento de dados e métodos).

Promovendo transparência e ciência aberta

Ciência é um empreendimento social: grupos independentes e colaborativos trabalham para acumular conhecimento como um bem público. A credibilidade das afirmações científicas é enraizado na evidência que o suporta, o que inclui a metodologia aplicada, os dados coletados e o processo de implementação da metodologia, análise de dados e interpretação dos resultados. Afirmações se tornam credíveis com a comunidade revisando, criticando, estendendo e reproduzindo as evidências de apoio. Entretanto, sem transparência, afirmações apenas alcanças credibilidade baseada em crença na confiança ou autoridade do originador. Transparência é superior à crença.

Ciência aberta se refere ao método de fazer o conteúdo e processo de produção de evidências e afirmações transparente e acessível a outros. Transparência é um ideal científico e adicionar “aberto” deveria ser redundante. Na realidade, a ciência geralmente tem carência de abertura: vários artigos publicados não estão disponíveis para as pessoas sem uma assinatura pessoal ou institucional e a maior parte dos dados, materiais e códios que suportam os resultados da pesquisa não são tornados acessíveis, por exemplo, em um repositório público63, 64, Quadro 5.

Quadro 5 – Compartilhamento de dados

Compartilhar dados em repositórios públicos oferece grande vantagem em termos de responsabilidade, longevidade dos dados, eficiência e qualidade (por exemplo, reanálises podem detectar erros cruciais ou até fabricação de dados)84. Infelizmente, várias disciplinas científicas, incluindo o mais devotado ao estudo do comportamento humano, não tem uma cultura de abertura dos dados6. No passado, dados compartilhados raramente eram obrigados ou facilitados. Iniciativas recentes, entretanto, visam mudar a cultura normativa. Felizmente, essas iniciativas vão mudar a cultura do compartilhamento de dados. Uma vez aceitas como a norma, duvidamos que o compartilhamento de dados alguma vez saia de moda.

Transparência e promoção da abertura (TOP)

Em 2015, Nosel e seus colegas54 propuseram diretrizes de autor para ajudar periódicos e financiadores a adotar políticas de transparência e reprodutibilidade. A partir de novembro de 2016, haviam 757 periódicos e 64 organizações signatárias das diretrizes TOP. Por exemplo, o periódico Science decidiu “publicar artigos apenas se dos dados usados na análise estiverem disponíveis para qualquer pesquisador para fins de reprodução ou extensão da análise”65 e o conglomerado de publicações da Springer Nature adotaram políticas similares de compartilhamento de dados.

Distintivos para reconhecer práticas de ciência aberta

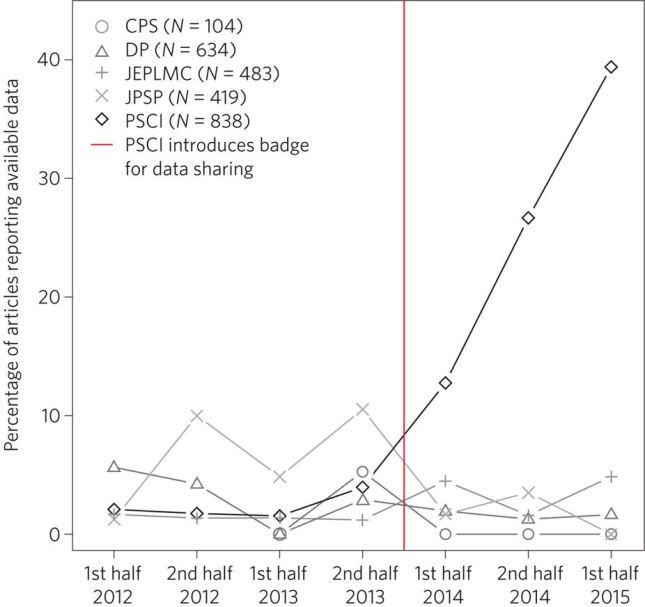

O Centro para Ciência aberta sugeriu que os periódicos designem um distintivo a artigos com dados abertos (bem como para outras práticas abertas, como pré-registro e materiais abertos). O propósito principal desses distintivos é assinalar que o periódico valoriza essas práticas. A revista Psychological Science adotou esses distintivos e há evidência de que o distintivo de dados abertos tem tido um efeito positivo, aumentando o compartilhamento de dados em mais de dez vezes (Figura 2).

A Iniciativa de Abertura da Revisão por Pares

Pesquisadores que assinam esse iniciativa (opennessinitiative.org) prometem que, como revisores, não oferecerão uma revisão abrangente para qualquer manuscrito que não torne torne seus dados publicamente disponíveis sem uma razão clara85.

Requisitos das agências de financiamento

Nos últimos anos, proeminentes agências de financiamento como o Research Councils UK no Reino Unido e o National Institutes of Health (NIH) e o National Science Foundation (NSF) nos Estados Unidos tem aumentado a pressão nos pesquisadores para compartilharem dados. Por exemplo, o Plano de Acesso Público da NIH de 2015 declara: “o NIH pretende tornar o acesso público para dados científicos digitais como padrão para todos os pesquisadores financiados pela NIH”. Desde 2010m NSF exige o envio de um plano de gerenciamento de dados que estipule como os dados devem ser guardados e compartilhados.

Muito pouco do processo de pesquisa (por exemplo, protocolos de estudo, fluxos de análise, revisão por pares) é acessível porque, historicamente, havia poucas oportunidades de tornar isso acessível mesmo que se quisesse. Isso tem motivado pedidos de acesso aberto, dados abertos e fluxos abertos (incluindo conduta de análise), mas há barreiras substanciais para atender a esses ideais, incluindo interesses financeiros adquiridos (particularmente em publicações acadêmicas) e poucos incentivos para que pesquisadores busquem práticas abertas. Por exemplo, as estruturas de incentivo atuais promovem a publicação de narrativas “limpas”, que podem exigir o relatório incompleto dos procedimentos ou resultados do estudo. Entretanto, a mudança está ocorrendo. As diretrizes TOP54, 55 promovem práticas abertas, enquanto um número crescente de publicações e financiadores exigem práticas abertas (por exemplo, dados abertos), com alguns oferecendo seus pesquisadores de graça, publicação de acesso aberto imediata com revisão por pares transparente depois da publicação (por exemplo, o Wellcome Trust, com o lançamento do Wellcome Open Research). Políticas para promover ciência aberta podem incluir diretrizes de relatório ou declarações de divulgação específicas (veja o Quadro 6). Ao mesmo tempo, organizações comerciais e sem fins lucrativos estão construindo novas infra-estruturas, como o Open Science Framework para tornar a transparência fácil e desejável para os pesquisadores.

Quadro 6 – Divulgação

A divulgação total refere-se ao processo de descrever na íntegra o projeto do estudo e os dados coletados que estão subjacentes aos resultados relatados, em vez de uma versão selecionada do projeto e/ou um subconjunto dos dados coletados. A necessidade para divulgação é clara: para avaliar adequadamente os resultados nós precisamos saber como eles foram obtidos. Por exemplo, o valor informativo de uma variável dependente exibindo um efeito de interesse é diferente se apenas uma variável ou se quinze foram coletadas. A probabilidade de uma simples variável alcançar P < 0.05 apenas pela chance é 5%, mas a probabilidade de uma de quinze variáveis alcançaram P < 0.05 é 54%54. É óbvio que a escolha a dedo de uma de quinze variáveis invalida o resultado a menos que esteja claro que isso aconteceu. Se os leitores sabem, então eles podem ajustar sua interpretação de acordo. A partir deste simples fato, segue que se autores não nos contarem que eles eles colheram um ou quinze variáveis, leitores não podem avaliar sua pesquisa51.A forma mais simples de divulgação é que os autores assegurem aos leitores através de uma declaração explícita em seu artigo que eles estão divulgando os dados totalmente. Isso pode ser visto como um simples elemento do guia de relatórios onde uma ênfase extra é colocada em alguns aspectos que são considerados mais essenciais à divulgação. Por exemplo, incluindo a seguinte declaração de 21 palavras: “Nós relatamos como determinamos o tamanho da amostra, todas as exclusões de dados (se houver), todas as manipulações e todas as medidas no estudo”86. Alternativamente, um processo mais complexo, mas também mais exigente e responsável é para periódicos que exijam declarações de divulgação explícitas e específicas. O periódico Psychological Science, por exemplo, agora exige que os autores “confirmem (a) o número total de observações excluídas e (b) as razões para fazer essas exclusões foram reportadas na seção Metodologia”87.

Avaliação

Nesta seção nós descrevemos medidas que podem ser implementadas quando da avaliação da pesquisa (incluindo, por exemplo, revisão por pares).

Diversificando a revisão por pares

Durante a maior parte da história da publicação científica, duas funções foram confundidas – avaliação e disseminação. Periódicos proveem disseminação através da triagem e entrega de conteúdo para a comunidade de pesquisadores e seleção através de revisão por pares para determinar o que vale a pena divulgar. Entretanto, com o advento da Internet, pesquisadores individuais não são mais dependentes de periódicos vincular, imprimir e enviar suas pesquisas a assinantes. Disseminação agora é fácil e pode ser controlada pelos próprios pesquisadores. Por exemplo, serviços de pré-publicação (arXiv para algumas ciências físicas, bioRxiv e PeerJ para ciências da vida, engrXiv para engenharia, PsyArXiv para psicologia e SocArXiv e Social Science Research Network (SSRN) para as ciências sociais) facilitam o compartilhamento, triagem e descoberta da pesquisa antes da publicação. Isso acelera dramaticamente a disseminação de informação para a comunidade de pesquisa.

Com o aumento da facilidade de disseminação, o papel dos editores como guardiões está em declínio. No entanto, o outro papel dos editores — avaliação — se mantém como parte vital do empreendimento de pesquisa. Convencionalmente, um editor de periódico vai selecionar um limitado número de revisores para avaliar a adequação de um envio para um periódico em particular. Entretanto, processos de avaliação mais diversos estão emergindo, permitido que a sabedoria coletiva da comunidade científica seja aproveitada66. Por exemplo, alguns serviços de pré-publicação permitem comentários públicos nos manuscritos, uma forma de revisão anterior à publicação que pode ser usada para melhorar o manuscrito. Outros serviços, como o PubMed Commons e o PubPeer, oferecem plataformas públicas para comentar nos trabalhos publicados, facilitando a revisão por pares pós-publicação. Ao mesmo tempo, alguns periódicos estão triando revisões “livres de resultado”, onde decisões editoriais para aceitação são baseadas somente em revisão da base lógica e métodos de estudo sozinhos (é isso, cego ao resultado)67.

Tanto mecanismos de revisão por pares pré quanto pós publicação aceleram e expandem dramaticamente o processo de avaliação68. Ao compartilhar pré-impressões, os pesquisadores podem obter feedback rápido sobre seu trabalho de uma comunidade diversa, ao invés de esperar vários meses para algumas críticas no processo convencional de revisão por pares. Usando serviços de pós-publicação, revisores podem fazer comentários positivos e críticos em artigos instantaneamente, ao invés de confiar no processo laborioso, incerto e demorado de criar um comentário e submetê-lo ao editor do periódico para possível publicação, eventualmente.

Como as formas públicas de revisão pré e pós publicação, esses novos serviços introduzem o potencial para novas formas de crédito e aprimoramento de reputação69. NO modelo convencional, a revisão por pares é feita privadamente, anonimamente e puramente como um serviço. Com sistemas de comentários públicos, um revisor que escolha ser identificado pode ganhar (ou perder) reputação baseado na qualidade da revisão. Há vários riscos possíveis e perceptíveis de revisões não anônimas que os avaliadores devem considerar e a pesquisa precisa avaliar, mas há evidência de que a revisão por pares aberta melhora a qualidade das revisões recebidas70. A oportunidade para uma comunicação acadêmica acelerada pode melhorar tanto o ritmo da descoberta quanto diversificar os meios de ser um contribuidor ativo para o raciocínio científico.

Incentivos

Publicação é a moeda da ciência acadêmica e aumenta a probabilidade de emprego, financiamento, promoção e permanência no cargo. Entretanto, nem todos os pesquisadores são igualmente publicáveis. Resultados positivos, originais e limpos tem mais probabilidade de serem publicados do que os resultados negativos, replicações e resultados com pontas soltas. Como consequência, pesquisadores são incentivados a produzir o antigo, mesmo ao custo da precisão40. Esses incentivos, em última análise, aumentam a probabilidade de falsos positivos na literatura publicada71. Destacar os incentivos , portanto, oferece uma oportunidade para aumentar a credibilidade e reprodutibilidade dos resultados publicados. Por exemplo, com simulações, Munafò e Higginson desenvolveram um modelo de otimização que prevê a estratégia de pesquisa mais racional, em termos da proporção do esforço da pesquisa gasto na busca de novos resultados ao invés de em estudos de confirmação e a quantidade de esforço de pesquisa por estudo exploratório72. Isso demonstrou que, para valores de parâmetros derivados da literatura científica, pesquisadores agindo para maximizar sua “aptidão” devem gastar a maioria dos seus esforços buscando resultados novos e conduzindo pequenos estudos que tem poder estatístico de apenas 10-40%. Criticamente, seu modelo sugere que alterando as estruturas de incentivo, ao considerar mais o resultado de um pesquisador e dar menos peso a descobertas surpreendentemente novas ao tomar decisões de nomeação e promoção, encorajaria uma mudança no comportamento do pesquisador que, em última análise, melhoraria o valor científico da pesquisa.

Financiadores, editoras, sociedades, instituições, editores, revisores e autores contribuem para as normas culturais que criam e sustentam os incentivos disfuncionais. Mudar os incentivos, portanto, é um problema que requer um esforço coordenado de todas as partes interessadas para alterar as estruturas de recompensa. Sempre haverá incentivos para resultados inovadores — aqueles que descobrem coisas novas serão recompensados mais do que aqueles que não o fazem. Entretanto, também pode haver incentivos para eficiência e eficácia – aqueles que conduzem pesquisas rigorosas, transparentes e reprodutíveis podem ser recompensados mais do que aqueles que não o fazem. Há exemplos promissores de intervenções eficazes para encorajar incentivos. Por exemplo, publicações estão adotando emblemas para reconhecer práticas abertas (Figura 2), Relatórios Registrados como um modelo de publicação cego ao resultado (veja o Quadro 3) e diretrizes TOP para promover abertura e transparência. Financiadores também estão adotando requisitos de transparência e pilotando registros mecanismos de financiamento para promover a reprodutibilidade, como o Netherlands Organisation for Scientific Research (NWO) e o US National Science Foundation’s Directorate of Social, Behavioral and Economic Sciences, ambos os quais anunciaram oportunidades de financiamento para estudos de replicação. As instituições estão lutando com ajustes de políticas e infra-estrutura para promover o compartilhamento de dados, e há dicas de práticas de ciência aberta que se tornam parte da contratação e avaliação de desempenho (por exemplo: www.nicebread.de/open-science-hiring-practices/). Coletivamente e em escala, tais esforços podem mudar os incentivos, de modo que o que é bom para o cientista também seja bom para a ciência — práticas de pesquisa rigorosas, transparentes e reprodutíveis que produzem resultados credíveis.

Imagem 2: o impacto de introduzir distintivos para compartilhamento de dados

Em janeiro de 2014, o periódico Psychological Science (PSCI) introduziu distintivos para artigos com dados abertos. Imediatamente depois disso, a proporção de artigos com dados abertos aumentou abruptamente e, em outubro de 2015, 38% dos artigos na Psychological Science tinham dados abertos. Para comparação, em outros periódicos (Clinical Psychological Science (CPS), Developmental Psychology (DP), Journal of Experimental Psychology: Learning, Memory and Cognition (JEPLMC) e Journal of Personality and Social Psychology (JPSP)) a proporção de artigos com dados abertos se manteve uniformemente baixo. A figura foi adaptada da referência 75, PLoS.

Conclusão

Os desafios para ciência reprodutível são sistêmicos e culturais, mas isso não significa que não possam ser alcançados. As medidas que descrevemos constituem passos práticos e alcançáveis para melhorar o rigor e a reprodutibilidade. Todos eles demonstraram alguma efetividade e são adequados para uma adoção, avaliação e melhorias mais amplas. Igualmente, essas propostas não são uma lista exaustiva, há várias outras ideias nascentes e amadurecidas para fazer as práticas de pesquisa mais eficientes e confiáveis73. Oferecer uma solução para um problema não garante sua efetividade e mudanças em normas culturais e incentivos podem estimular mudanças comportamentais adicionais que são difíceis de antecipar. Algumas soluções podem ser inficazes ou até prejudiciais para a eficiência e confiabilidade da ciência, mesmo que conceitualmente aparentem ser sensíveis.

O campo da metaciência (ou metapesquisa) está crescendo rapidamente, com mais de 2 mil publicações relevantes anuais16. Muito desta literatura constitui a avaliação de práticas existentes e a identificação de abordagens alternativas. O que anteriormente era tido como certo pode ser questionado, como métodos estatísticos largamente utilizados. Por exemplo, os métodos métodos e softwares mais populares para análises de extensão espacial em imagens de ressonância magnética funcional recentemente demonstraram produzir uma taxa inaceitavelmente alta de falsos positivos 74. Soluções propostas também podem dar origem a outros desafios. Por exemplo, enquanto replicação é uma marca que reforça a confiança em resultados científicos, há incertezas sobre quais estudos merecem ser replicados e quais seriam as estratégias de replicação mais eficientes. Além disso, uma simulação recente sugere que a replicação por si só pode não ser suficiente para nos livrar de resultados falsos71.

Esses cuidados não são um raciocínio para a inércia. Práticas de pesquisa reprodutíveis são o cerne da investigação e parte integrante do método científico. A melhor forma de acumular conhecimento de forma rigorosa e eficiente é uma questão científica. As soluções mais efetivas terão de ser identificadas pela combinação de hipóteses brilhantes e sorte cega, pelo exame iterativo da efetividade de cada mudança e por uma ciranda de muitas possibilidades para poucos escolhidos. A verdadeira compreensão de como melhor estruturar e incentivar a ciência emergirá lentamente e nunca terminará. É assim que a ciência funciona. A chave para promover uma metaciência robusta que avalie e melhore as práticas é que as partes interessadas na ciência não abracem o status quo, mas ao invés disso, procedam um auto-exame contínuo para a melhoria e auto-correção do processo científico em si.

Como disse Richard Feynman, “o primeiro princípio é que você não deve se enganar – e você é a pessoa mais fácil de enganar”.

Referências

- IOANNIDIS, J. P. A. Why most published research findings are false. PLoS Med.2, e124 (2005).

- BUTTON, K. S. et al. Power failure: why small sample size undermines the reliability of neuroscience. Nat. Rev. Neurosci.14, 365–376 (2013).

CAS | PubMed | Artigo - FANELLI, D. “Positive” results increase down the Hierarchy of the Sciences. PloS ONE5, e10068 (2010).

- JOHN, L. K., Loewenstein, G. & Prelec, D. Measuring the prevalence of questionable research practices with incentives for truth telling. Psychol. Sci.23, 524–532 (2012).

PubMed | Artigo - MAKEL, M. C., Plucker, J. A. & Hegarty, B. Replications in psychology research: how often do they really occur?Perspect. Psychol. Sci.7, 537–542 (2012).

Artigo - WICHERTS, J. M., Borsboom, D., Kats, J. & Molenaar, D. The poor availability of psychological research data for reanalysis. Am. Psychol.61, 726–728 (2006).

PubMed | Artigo - KERR, N. L. HARKing: hypothesizing after the results are known. Pers. Soc. Psychol. Rev.2, 196–217 (1998).

CAS | PubMed | Artigo - Al-Shahi Salman, R. et al. Increasing value and reducing waste in biomedical research regulation and management. Lancet383, 176–185 (2014).

PubMed | Artigo - BEGLEY, C. G. & IOANNIDIS, J. P. Reproducibility in science: improving the standard for basic and preclinical research. Circ. Res.116, 116–126 (2015).

CAS | PubMed | Artigo - CHALMERS, I. et al. How to increase value and reduce waste when research priorities are set. Lancet383, 156–165 (2014).

PubMed | Artigo - CHAN, A. W. et al. Increasing value and reducing waste: addressing inaccessible research. Lancet383, 257–266 (2014).

PubMed | Artigo - GLASZIOU, P. et al. Reducing waste from incomplete or unusable reports of biomedical research. Lancet383, 267–276 (2014).

PubMed | Artigo - IOANNIDIS, J. P. et al. Increasing value and reducing waste in research design, conduct, and analysis. Lancet383, 166–175 (2014).

PubMed | Artigo - MACLEOD, M. R. et al. Biomedical research: increasing value, reducing waste. Lancet383, 101–104 (2014).

PubMed | Artigo - BAKER, M. 1,500 scientists lift the lid on reproducibility. Nature533, 452–454 (2016).

CAS | PubMed | Artigo - IOANNIDIS, J. P., Fanelli, D., Dunne, D. D. & Goodman, S. N. Meta-research: evaluation and improvement of research methods and practices. PLoS Biol.13, e1002264 (2015).

- PANETH, N. Assessing the contributions of John Snow to epidemiology: 150 years after removal of the broad street pump handle. Epidemiology15, 514–516 (2004).

Artigo - BERKER, E. A., BERKER, A. H. & SMITH, A. Translation of Broca’s 1865 report. Localization of speech in the third left frontal convolution. Arch. Neurol. 43, 1065–1072 (1986).

CAS | PubMed | Artigo - WADE, N. Discovery of pulsars: a graduate student’s story. Science189, 358–364 (1975).

Artigo - NICKERSON, R. S. Confirmation bias: a ubiquitous phenomenon in many guises. Rev. Gen. Psychol.2, 175–220 (1998).

Artigo - LEVENSON, T. The Hunt for Vulcan…and How Albert Einstein Destroyed a Planet, Discovered Relativity, and Deciphered the University (Random House, 2015).

- ROSENTHAL, R. Experimenter Effects in Behavioral Research (Appleton-Century-Crofts, 1966).

- DE GROOT, A. D. The meaning of “significance” for different types of research [translated and annotated by Eric-Jan Wagenmakers, Denny Borsboom, Josine Verhagen, Rogier Kievit, Marjan Bakker, Angelique Cramer, Dora Matzke, Don Mellenbergh, and Han L. J. van der Maas]. Acta Psychol.148, 188–194 (2014).

Artigo - HEININGA, V. E., Oldehinkel, A. J., Veenstra, R. & Nederhof, E. I just ran a thousand analyses: benefits of multiple testing in understanding equivocal evidence on gene-environment interactions. PloS ONE10, e0125383 (2015).

- PATEL, C. J., Burford, B. & Ioannidis, J. P. Assessment of vibration of effects due to model specification can demonstrate the instability of observational associations. J. Clin. Epidemiol.68, 1046–1058 (2015).

Artigo - CARP, J. The secret lives of experiments: methods reporting in the fMRI literature. Neuroimage63, 289–300 (2012).

PubMed | Artigo - CARP, J. On the plurality of (methodological) worlds: estimating the analytic flexibility of FMRI experiments. Front. Neurosci.6, 149 (2012).

- SIMONSOHN, U., Nelson, L. D. & Simmons, J. P. P-curve: a key to the file-drawer. J. Exp. Psychol. Gen.143, 534–547 (2014).

Artigo - NUZZO, R. Fooling ourselves. Nature526, 182–185 (2015).

CAS | PubMed | Artigo - MACCOUN, R. & Perlmutter, S. Blind analysis: hide results to seek the truth. Nature526, 187–189 (2015).

PubMed | Artigo - GREENLAND, S. et al. Statistical tests, P values, confidence intervals, and power: a guide to misinterpretations. Eur. J. Epidemiol.31, 337–350 (2016).

PubMed | Artigo - STERNE, J. A. & Davey Smith, G. Sifting the evidence—what’s wrong with significance tests?BMJ322, 226–231 (2001).

CAS | PubMed | Artigo - BRAND, A., Bradley, M. T., Best, L. A. & Stoica, G. Accuracy of effect size estimates from published psychological research. Percept. Motor Skill. 106, 645–649 (2008).

Artigo - VANKOV, I., Bowers, J. & Munafò, M. R. On the persistence of low power in psychological science. Q. J. Exp. Psychol.67, 1037–1040 (2014).

Artigo - SEDLMEIER, P. & Gigerenzer, G. Do studies of statistical power have an effect on the power of studies?Psychol. Bull.105, 309–316 (1989).

Artigo - COHEN, J. The statistical power of abnormal-social psychological research: a review. J. Abnorm. Soc. Psychol.65, 145–153 (1962).

Artigo - ETTER, J. F., Burri, M. & Stapleton, J. The impact of pharmaceutical company funding on results of randomized trials of nicotine replacement therapy for smoking cessation: a meta-analysis. Addiction102, 815–822 (2007).

Artigo - ETTER, J. F. & Stapleton, J. Citations to trials of nicotine replacement therapy were biased toward positive results and high-impact-factor journals. J. Clin. Epidemiol.62, 831–837 (2009).

Artigo - PANAGIOTOU, O. A. & Ioannidis, J. P. Primary study authors of significant studies are more likely to believe that a strong association exists in a heterogeneous meta-analysis compared with methodologists. J. Clin. Epidemiol.65, 740–747 (2012).

Artigo - NOSEK, B. A., Spies, J. R. & Motyl, M. Scientific utopia: II. Restructuring incentives and practices to promote truth over publishability. Perspect. Psychol. Sci.7, 615–631 (2012).

PubMed | Artigo - BATH, P. M. W., Macleod, M. R. & Green, A. R. Emulating multicentre clinical stroke trials: a new paradigm for studying novel interventions in experimental models of stroke. Int. J. Stroke4, 471–479 (2009).

CAS | PubMed | Artigo - DIRNAGL, U. et al. A concerted appeal for international cooperation in preclinical stroke research. Stroke44, 1754–1760 (2013).

PubMed | Artigo - MILIDONIS, X., Marshall, I., Macleod, M. R. & Sena, E. S. Magnetic resonance imaging in experimental stroke and comparison with histology systematic review and meta-analysis. Stroke46, 843–851 (2015).

Artigo - KLEIN, R. A. et al. Investigating variation in replicability: a “many labs” replication project. Soc. Psychol.45, 142–152 (2014).

Artigo - EBERSOLE, C. R. et al. Many Labs 3: evaluating participant pool quality across the academic semester via replication. J. Exp. Soc. Psychol.67, 68–82 (2016).

Artigo - LENZER, J., Hoffman, J. R., Furberg, C. D. & Ioannidis, J. P. A. Ensuring the integrity of clinical practice guidelines: a tool for protecting patients. BMJ347, f5535 (2013).

- STERLING, T. D. Publication decisions and their possible effects on inferences drawn from tests of significance—or vice versa. J. Am. Stat. Assoc.54, 30–34 (1959).

Artigo - ROSENTHAL, R. File drawer problem and tolerance for null results. Psychol. Bull.86, 638–641 (1979).

Artigo - STERLING, T. D. Consequence of prejudice against the null hypothesis. Psychol. Bull.82, 1–20 (1975).

Artigo - FRANCO, A., Malhotra, N. & Simonovits, G. Publication bias in the social sciences: unlocking the file drawer. Science345, 1502–1505 (2014).

Artigo - SIMMONS, J. P., Nelson, L. D. & Simonsohn, U. False-positive psychology: undisclosed flexibility in data collection and analysis allows presenting anything as significant. Psychol. Sci.22, 1359–1366 (2011).

PubMed | Artigo - CHAMBERS, C. D. Registered Reports: a new publishing initiative at Cortex. Cortex49, 609–610 (2013).

PubMed | Artigo - NOSEK, B. A. & Lakens, D. Registered Reports: a method to increase the credibility of published results. Soc. Psychol.45, 137–141 (2014).

Artigo - NOSEK, B. A. et al. Promoting an open research culture. Science348, 1422–1425 (2015).

CAS | PubMed | Artigo - BEGG, C. et al. Improving the quality of reporting of randomized controlled trials: the CONSORT statement. JAMA276, 637–639 (1996).

CAS | PubMed | Artigo - MOHER, D., Dulberg, C. S. & Wells, G. A. Statistical power, sample size, and their reporting in randomized controlled trials. JAMA272, 122–124 (1994).

Artigo - SCHULZ, K. F., Altman, D. G., Moher, D. & Group, C. CONSORT 2010 statement: updated guidelines for reporting parallel group randomised trials. BMJ340, c332 (2010).

- GRANT, S. et al. Developing a reporting guideline for social and psychological intervention trials. Res. Social Work Prac.23, 595–602 (2013).

Artigo - LIBERATI, A. et al. The PRISMA statement for reporting systematic reviews and meta-analyses of studies that evaluate health care interventions: explanation and elaboration. PLoS Med.6, e1000100 (2009).

- Shamseer, L. et al. Preferred reporting items for systematic review and meta-analysis protocols (PRISMA-P) 2015: elaboration and explanation. BMJ349, g7647 (2015); erratum 354, i4086 (2016).

- VAN‘T VEER, A. & Giner-Sorolla, R. Pre-registration in social psychology: a discussion and suggested template. J. Exp. Soc. Psychol.67, 2–12 (2016).

Artigo - FRANCO, A., Malhotra, N. & Simonovits, G. Underreporting in psychology experiments: evidence from a study registry. Soc. Psychol. Per. Sci.7, 8–12 (2016).

Artigo - ALSHEIKH-ALI, A. A., QURESHI, W., AL-MALLAH, M. H. & IOANNIDIS, J. P. Public availability of published research data in high-impact journals. PloS ONE6, e24357 (2011).

- IQBAL, S. A., WALLACH, J. D., KHOURY, M. J., SCHULLY, S. D. & IOANNIDIS, J. P. Reproducible research practices and transparency across the biomedical literature. PLoS Biol.14, e1002333 (2016).

- MCNUTT, M. Taking up TOP. Science352, 1147 (2016).

- PARK, I. U., PEACEY, M. W. & MUNAFÒ, M. R. Modelling the effects of subjective and objective decision making in scientific peer review. Nature506, 93–96 (2014).

Artigo - BUTTON, K. S., BAL, L., CLARK, A. G. & SHIPLEY, T. Preventing the ends from justifying the means: withholding results to address publication bias in peer-review. BMC Psychol.4, 59 (2016).

- BERG, J. M. et al. Preprints for the life sciences. Science352, 899–901 (2016).

Artigo - NOSEK, B. A. & BAR-ANAN, T. Scientific utopia: I. Opening scientific communication. Psychol. Inq.23, 217–243 (2012).

Artigo - WALSH, E., ROONEY, M., APPLEBY, L. & WILKINSON, G. Open peer review: a randomised trial. Brit. J. Psychiat.176, 47–51 (2000).

Artigo - SMALDINO, P. E. & MCELREATH, R. The natural selection of bad science. R. Soc. Open Sci.3, 160384 (2016).

- HIGGINSON, A. D. & MUNAFÒ, M. Current incentives for scientists lead to underpowered studies with erroneous conclusions. PLoS Biol.14, e2000995 (2016).

- IOANNIDIS, J. P. How to make more published research true. PLoS Med.11, e1001747 (2014).

- EKLUND, A., NICHOLS, T. E. & KNUTSSON, H. Cluster failure: why fMRI inferences for spatial extent have inflated false-positive rates. Proc. Natl Acad. Sci. USA113, 7900–7905 (2016). CAS

PubMed | Artigo - KIDWELL, M. C. et al. Badges to acknowledge open practices: a simple, low-cost, effective method for increasing transparency. PLoS Biol.14, e1002456 (2016).

- MUNAFÒ, M. et al. Scientific rigor and the art of motorcycle maintenance. Nat. Biotechnol.32, 871–873 (2014).

Artigo - KASS, R. E. et al. Ten simple rules for effective statistical practice. PLoS Comput. Biol.12, e1004961 (2016).

- SCHWEINSBERG, M. et al. The pipeline project: pre-publication independent replications of a single laboratory’s research pipeline. J. Exp. Psychol. Gen.66, 55–67 (2016).

- STEVENS, A. et al. Relation of completeness of reporting of health research to journals’ endorsement of reporting guidelines: systematic review. BMJ348, g3804 (2014).

- KILKENNY, C. et al. Survey of the quality of experimental design, statistical analysis and reporting of research using animals. PloS ONE4, e7824 (2009).

- BAKER, D., LIDSTER, K., SOTTOMAYOR, A. & AMOR, S. Two years later: journals are not yet enforcing the ARRIVE guidelines on reporting standards for pre-clinical animal studies. PLoS Biol.12, e1001756 (2014).

- GULIN, J. E., ROCCO, D. M. & GARCIA-BOURNISSEN, F. Quality of reporting and adherence to ARRIVE guidelines in animal studies for Chagas disease preclinical drug research: a systematic review. PLoS Negl. Trop. Dis. 9, e0004194 (2015).

- LIU, Y. et al. Adherence to ARRIVE guidelines in Chinese journal reports on neoplasms in animals. PloS ONE11, e0154657 (2016).

- GOTZSCHE, P. C. & IOANNIDIS, J. P. Content area experts as authors: helpful or harmful for systematic reviews and meta-analyses?BMJ345, e7031 (2012).

- MOREY, R. D. et al. The Peer Reviewers’ Openness Initiative: incentivizing open research practices through peer review. R. Soc. Open Sci.3, 150547 (2016).

- SIMMONS, J. P., NELSON, L. D. & SIMONSOHN, U. A 21 word solution. Preprint at dx.doi.org/10.2139/ssrn.2160588(2012).

- EICH, E. Business not as usual. Psychol. Sci.25, 3–6 (2014).

Artigo

Tradução: Maurício Moura